众所周知,小红书是国内最火热的种草社交平台,拥有海量的高品质用户,尤其以女性用户居多,相对于其他平台更具有消费能力。平台上的爆火笔记也成为众多媒体从业者的分析对象。于是,我用python开发了一个爬虫采集软件,可自动按笔记链接抓取笔记的详情数据,达到分析竞品笔记、仿写笔记提供了数据基础。

众所周知,小红书是国内最火热的种草社交平台,拥有海量的高品质用户,尤其以女性用户居多,相对于其他平台更具有消费能力。平台上的爆火笔记也成为众多媒体从业者的分析对象。于是,我用python开发了一个爬虫采集软件,可自动按笔记链接抓取笔记的详情数据,达到分析竞品笔记、仿写笔记提供了数据基础。

我用python开发了一个爬虫采集软件,可自动按笔记链接抓取笔记的详情数据。

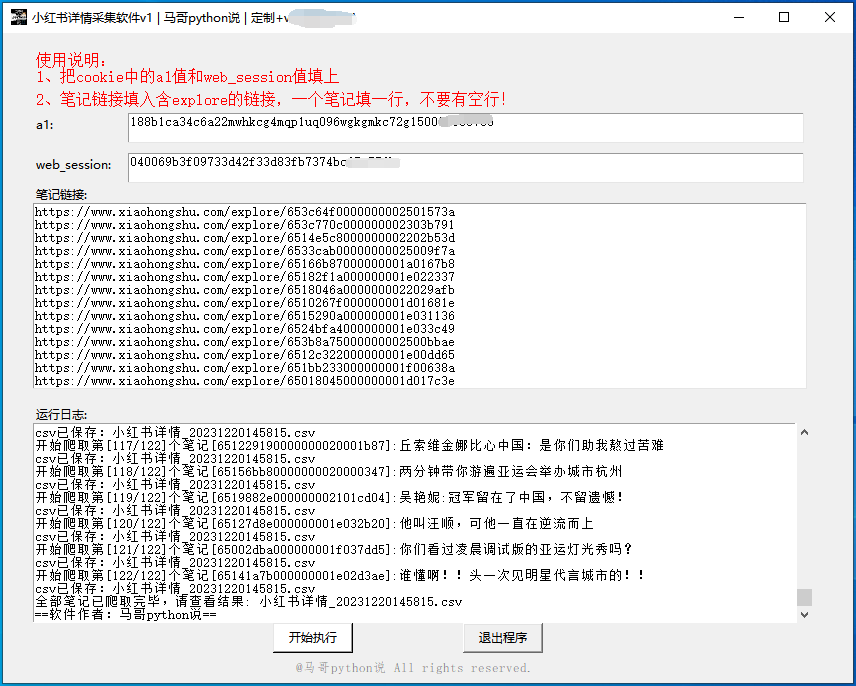

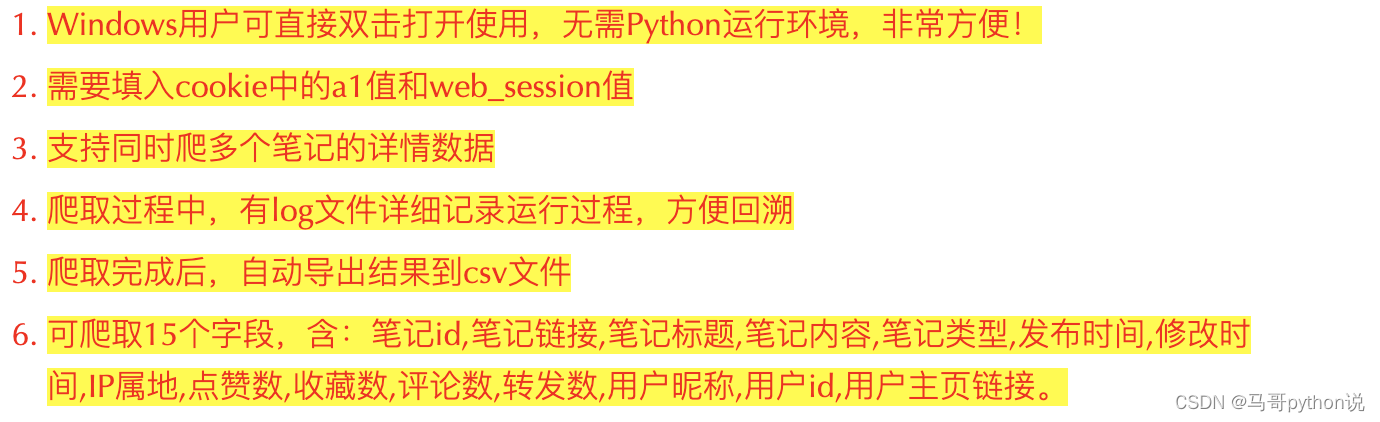

为什么有了源码还开发界面软件呢?方便不懂编程代码的小白用户使用,无需安装python,无需改代码,双击打开即用!

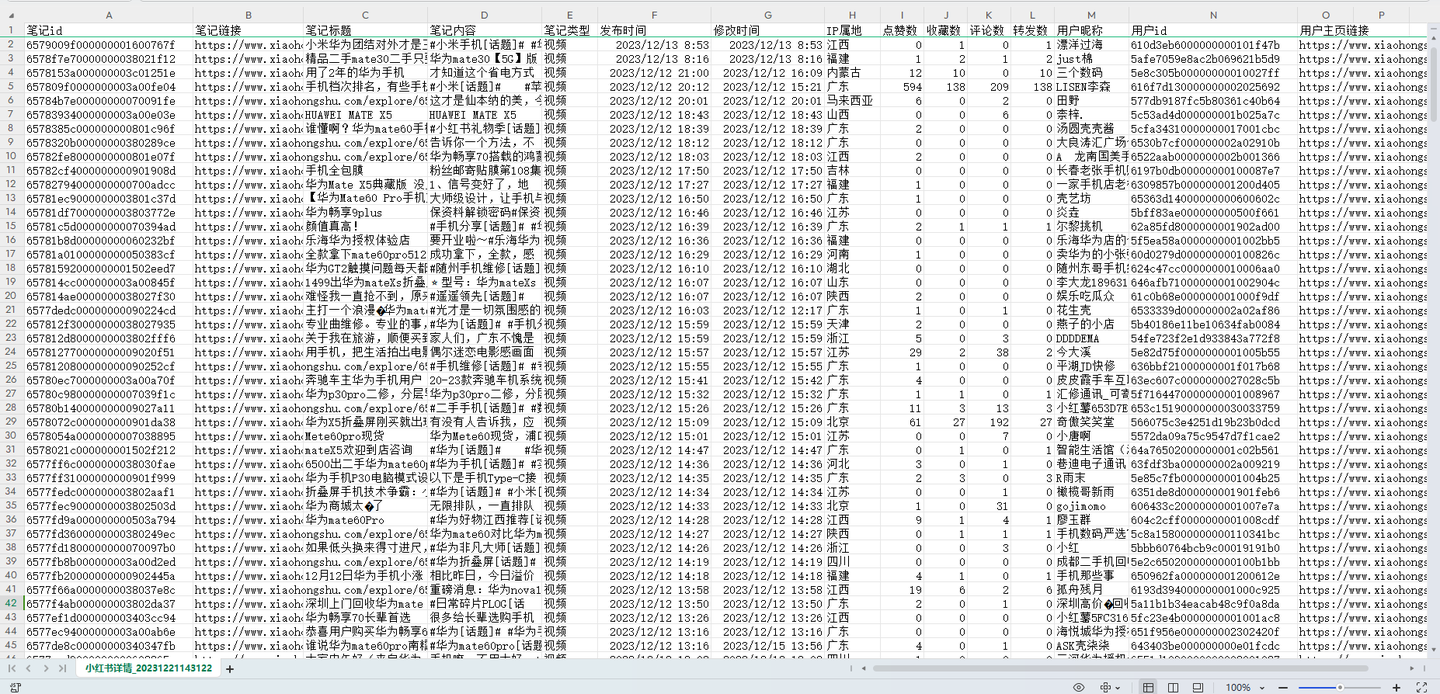

软件界面截图:  · 爬取结果截图:

· 爬取结果截图:

软件使用演示:

几点重要说明: 以上。

以上。

首先,定义接口地址作为请求地址:

定义一个请求头,用于伪造浏览器:

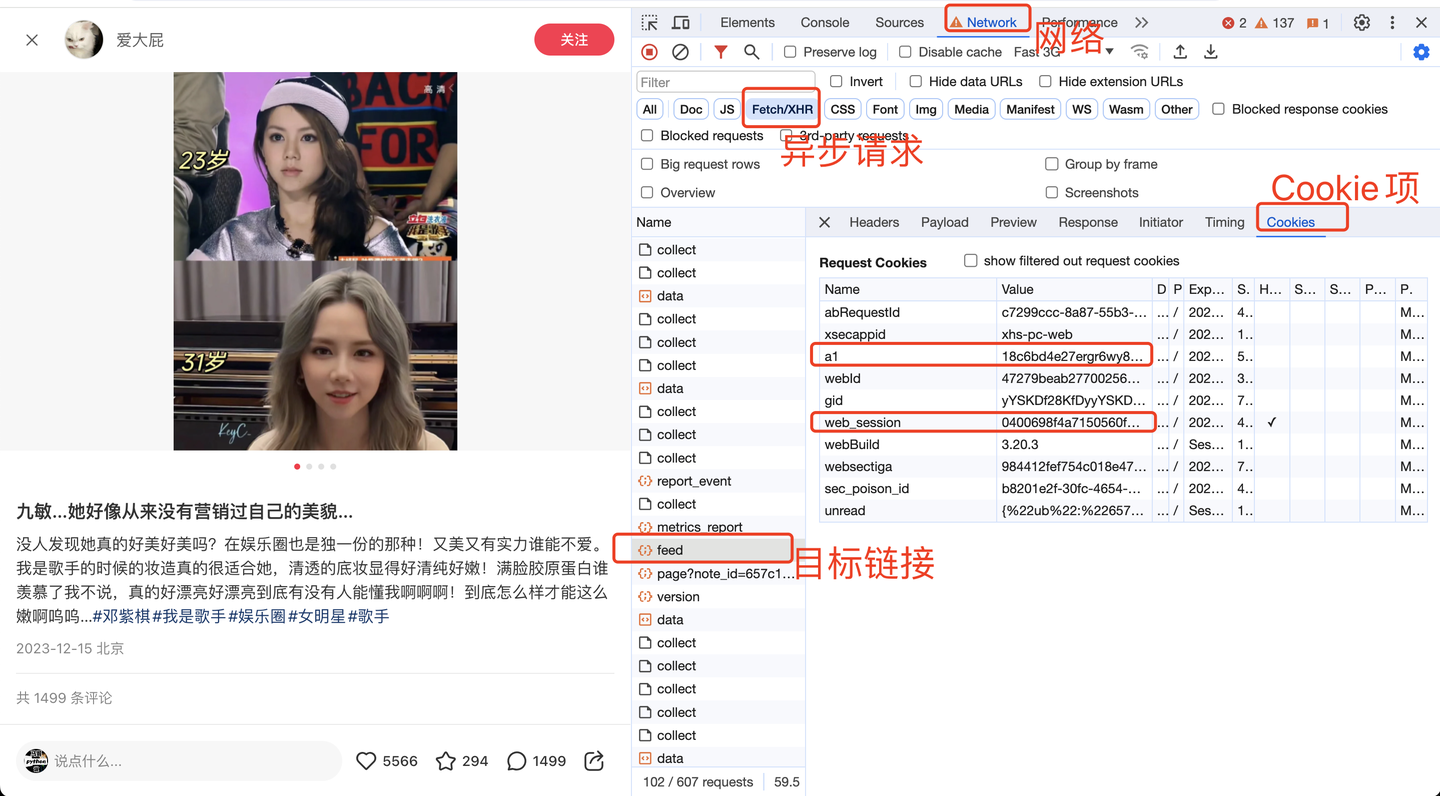

说明一下,cookie是个关键参数。

其中,cookie里的a1和web_session获取方法,如下:

这两个值非常重要,软件界面需要填写!!

加上请求参数,告诉程序你的爬取条件是什么:

下面就是发送请求和接收数据:

逐个解析字段数据,以"笔记标题"为例:

熟悉xhs的朋友都知道,有些笔记是没有标题的,所以这里加上try保护,防止程序报错导致中断运行。

其他字段同理,不再赘述。

最后,是把数据保存到csv文件:

这里采用csv库保存数据,方便每爬取一条笔记数据,快速保存到csv文件中。

完整代码中,还含有:判断循环结束条件、转换时间戳、js逆向解密等关键实现逻辑,详见文末。

主窗口部分:

输入控件部分:

以上。

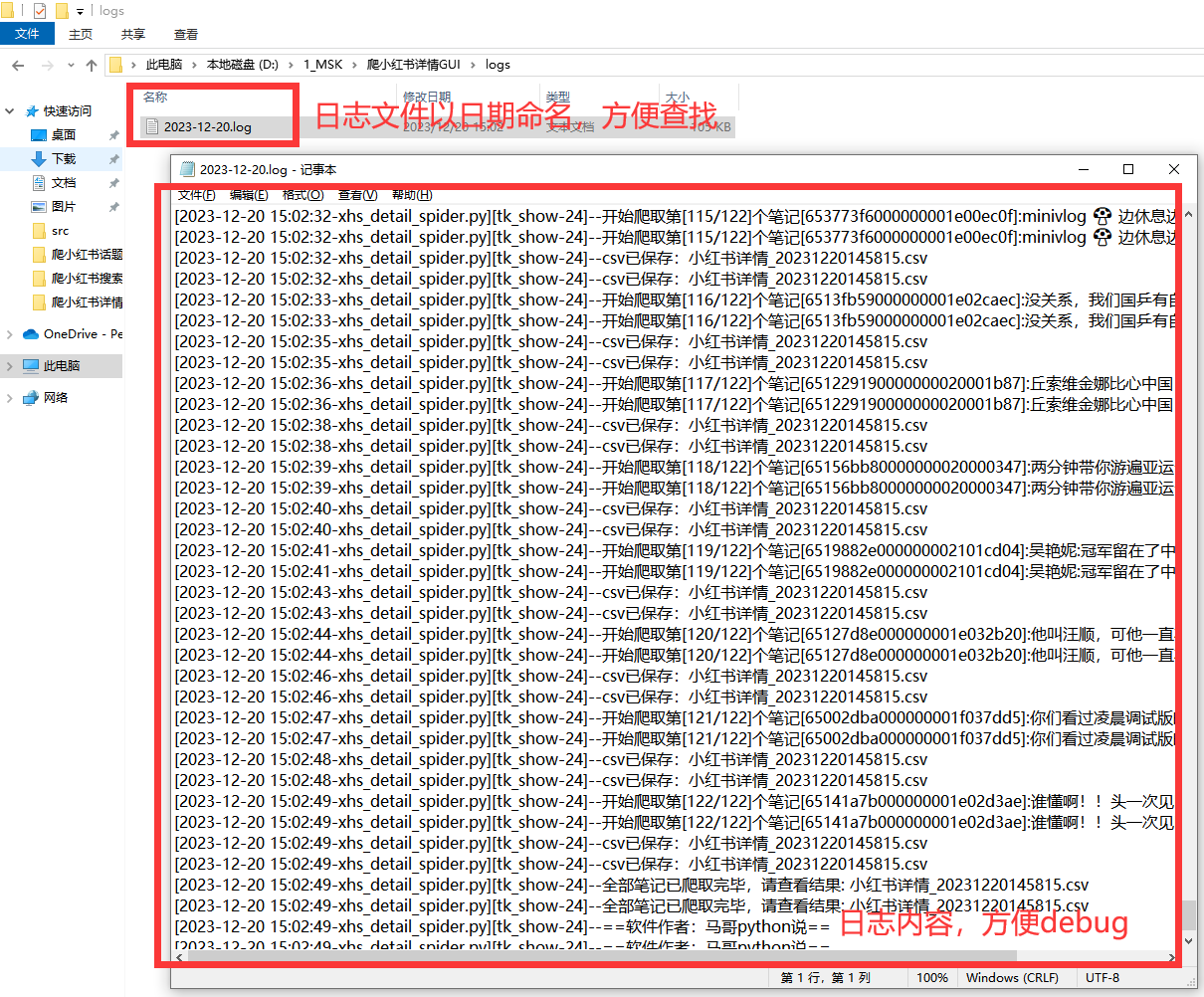

好的日志功能,方便软件运行出问题后快速定位原因,修复bug。

核心代码:

日志文件截图:

完整讲解、想你所想:

本文地址:http://lanlanwork.gawce.com/quote/8663.html 阁恬下 http://lanlanwork.gawce.com/ , 查看更多